AI 科技評論按:12 月 27 日 AI 科技評論去清華蹭了一個研討會,主題是「從阿爾法 Go 到通用人工智能:腦科學與人工智能」。

這是清華大學腦與智能實驗室自 12 月 15 日成立之后舉辦的首次學術研討會。

在這次研討會上,AI 科技評論第一次看到這么多腦科學家講怎么用老鼠、猴子做實驗。除此之外,AI 科技評論也聽到兩場非常引人深思的 AI 相關報告——一場為張鈸院士做的《 AI 和神經科學》,另一場是今日頭條 AI Lab 主任李航博士的《 NLP 現狀和未來》。

聽完之后 AI 科技評論深覺遺憾,為什么呢?因為張鈸院士和李航博士的報告非常值得 AI 研究人員細細品味,但在場的人并不是很多,且多數并不是「AIer」。

回來后 AI 科技評論決定根據現場拍的一些照片和做的一些筆記簡單還原一下張鈸院士的報告現場(沒能完整記錄李航博士的報告,sad!),聊解遺憾。

張鈸院士的報告全程英文,但最后用中文做了點睛之筆。

張鈸院士在報告中首先分析了什么是智能。他認為智能包含三個成分:perceive、rational thinking 和 taking action。綜合來說就是,一個智能體要能夠感知它周圍的環境,進行思考并采取行動來最大化它實現某些目的的機會。

現在的 AI model 無外乎兩種類型:符號模型(Symbolic model)和亞符號模型(Sub-symbolic model)或者稱為連接主義(Connectionism)。

符號模型

符號模型的基本思想主要由 J. McCarthy 等人于 1955 年提出。他們認為 AI 的研究基于這樣一個猜想,即學習或者任何其他的智能特征原則上都可以被精確地描述。他們提出兩個基本假設:

●物理符號系統假設:物理符號系統是智能的充分必要條件;

●人腦和計算機都是物理符號系統,認知過程就是在符號表示上的運算。

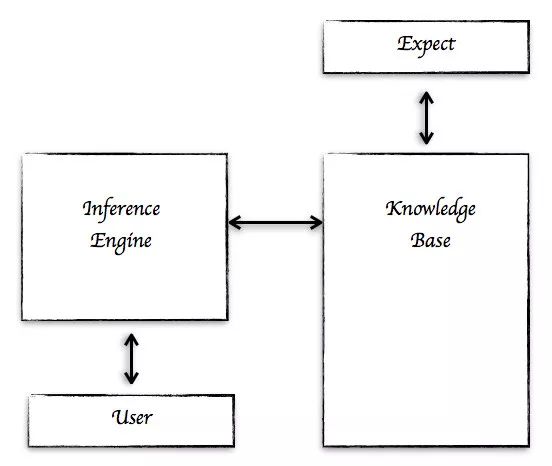

在 1976 年 Newell 和 Simon 提出了一個符號模型。它包含兩部分:知識庫和推理機(Inference Engine)。這種 AI 主要是知識驅動或者基于規則的模型。

在 McCarthy 等人提出符號模型之后大約 40 年,1997 年 IBM 推出的基于符號模型的 IBM 深藍(Deep Blue)在國際象棋比賽中以2 贏 1 敗 3 平打敗了當時的世界冠軍 Kaspanov。在深藍的系統中,包含了 700,000 份人類大師的棋譜,這些棋譜分別用 V-value 函數來表示,函數有 8000 多個變量。

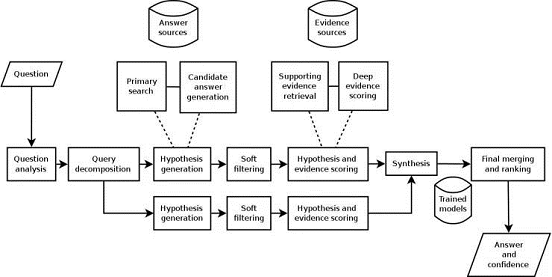

2011 年,IBM 沃森在綜藝節目《危險邊緣》中打敗了最高獎金得主布拉德·魯特爾和連勝紀錄保持者肯·詹寧斯。同樣它也是基于知識的符號型 AI 系統,它的知識來源于百科全書、字典 、詞典、新聞、文學作品以及維基百科的全部文本,在其 4TB 的磁盤中包含了 2 億頁結構化和非結構化的信息。

以Watson為代表的新一代的基于知識的符號模型系統相對之前有少許變化。其一是知識庫中的知識表示變成多樣化;其二是多推理機(Multi-Inference Engines)結構;其三是增加了大眾知識(來自互聯網)。

但是這種知識驅動的符號模型也有其局限之處,如下:

●有很多人類行為(知識)并不能精確描述,例如常識;

●知識庫總是有限的,它不能包含所有的信息;

●知識是確定的;

●它只能描述特定的領域;

●大量知識不能做到定量化(例如質量)。

所以這種模型只能在宏觀層面上用來模擬人類的某些行為。

亞符號模型/連接主義

1965 年,在達特茅斯夏季研討會的提議文件(http://t.cn/RAnjsCF)的問題 2 中說到「怎么安排一組(假設的)神經元來形成概念?……這個問題仍需要更多的理論工作。」

對于神經網絡,大致有兩個時期。第一個為淺層神經網絡(Shallow Neural Network),這個網絡只有一層隱藏層。在這種網絡中,需要手工特征(Hand-crafted Features)來構建分類器,因此它需要有領域的知識。

另外一種是在 2000-2006 年間,由 Igor Aizenberg 和 Geoff Hinton 完成。這個網絡有更多的隱藏層,稱為多隱藏層(深度)神經網絡。多隱藏層的結構帶來了很大的變化。首先是,我們可以用 Raw data 代替手工特征,所以領域知識也就不再是必須的了。以圖像為例,我們只需要將圖像按照 pixel 的格式輸入即可。其次,深度神經網絡讓亞符號模型的表現有了很大的提高。再次,在 90 年代 AI 研究人員發展了一系列成熟的統計數學工具,這在模型中有很多表現,讓模型變得更具可度量和可驗證性。另外,這個模型有很清晰的神經科學的解釋。

這種 AI 系統主要是基于數據驅動。只要有數據,我們不需要有太多的領域知識就可以在任務中做得很好。基于深度神經網絡的例子很多,例如 AlphaGo。

相比于人類的神經網絡,它仍有一系列的缺點。如下:

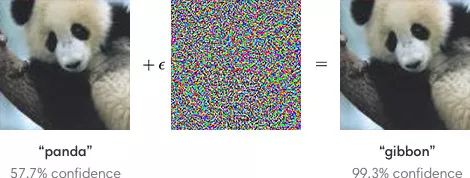

以 2014 年 Goodfellow 發表的《Adversarial examples and adversarial training》為例,輸入的圖片加上一點點的噪聲,AI 系統就將一張明顯是熊貓的圖片以 99.3% 的置信度識別成長臂猿。所以目前的 AI 系統在 robustness 上還是非常弱的。

這種 AI 系統只是一種分類機器,是一個 AI without Understanding,所以僅僅依靠基于數據驅動的深度學習很難產生真正的智能,也遠沒有觸及智能的核心。若想做到真正的智能,就必須

人工智能的核心

前面說道,深度學習并沒有觸及到人工智能的核心,那么人工智能的核心是什么呢?張鈸院士認為主要表現為以下五個方面:

●在缺乏知識和數據的情況下依然能夠完成任務;

●在信息不完善(甚至缺乏信息)的情況下依然能夠完成任務;

●能夠處理非確定性的任務;

●能夠處理動態任務;

●能夠處理多領域和多任務。

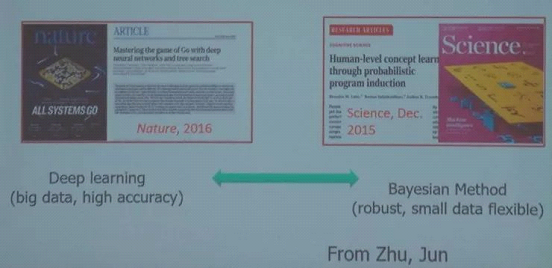

AI 研究的新趨勢

基于對上面的討論,可以看出目前 AI 的研究有兩種,基于知識的符號模型和基于數據的亞符號模型(連接主義)。張鈸院士認為現在在 AI 研究中漸漸出現了一種新的趨勢,即建立一種同時基于知識和數據的 AI 系統。

他認為,處理知識是人類所擅長的,而處理數據是計算機所擅長的。如果能夠將二者結合起來,一定能夠構建出一個比人類更加智能的系統。

如何去做呢?

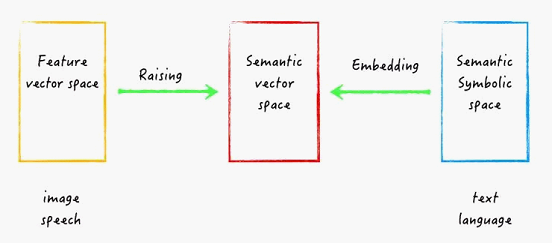

現在我們有兩種基本的 AI 方法。一種是基于語義符號的方法,一般用在處理文本和語言,我們會構建一個語義符號空間(Semantic Symbolic Space)。另一種是基于數據的特性向量的方法,用來處理圖像和語音,我們會構建一個特性向量空間(Feature Vector Space)。

因此我們可以構建一個新的空間,叫做語義向量空間(Semantic Vector Space),即將語義符號空間進行 embedding 處理或者將特性向量空間進行 Raising 處理。通過這種方法,我們將可以統一處理 text、language、image 和 speech。

張鈸院士認為在這些方面,尤其是在將特性向量空間 raising 到語義空間上,我們應該向神經科學學習。例如腦神經中有 feedback connection、lateral connections、sparse firing、attention mechanism、multi-model、memory 等機制,這些都值得設計 AI 系統的人員去注意和學習。

研究案例

張鈸院士介紹了四個案例來說明如何向神經科學學習,以及如何構建同時基于知識和數據的 AI 系統。(公眾號后臺發送「張鈸」,獲取四篇案例論文原文)

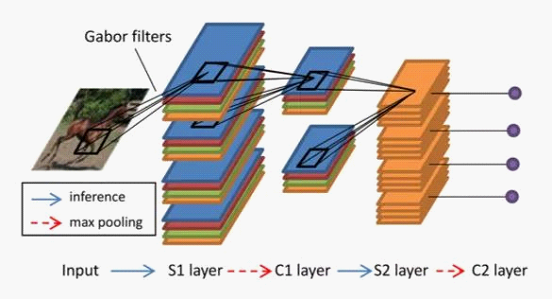

一、Sparse Firing + HMAX

論文:Sparsity-Regularized HMAX for Visual Recognition

這項工作的一個創新點在于將神經科學中的發現 Sparse firing 和 HMAX 結合在一起。

HMAX 模型是 Riesenhuber, M. & Poggio, T 等人于 1999 年提出,其理念是模仿人的認知,由點到線到面逐級抽象,還原高級特性。HMAX 是計算機視覺中非常重要的一個模型。

Sparse firing 是神經科學中的一個概念。神經科學的研究表明在人的大腦中,針對一個刺激大多數神經元是沉默的。例如依照大腦內細胞的密度、探針大小以及探針可以測量到的信號距離來估計,一根探針應該可以測到周圍十個甚至上百個神經元的信號,但實際情況通常只能測到幾個神經元信號,90% 以上的神經元是測不到的。這就是說針對一個刺激,只有少數(稀疏)神經元是被激活的。

大腦神經元的這種 sparse firing 激活方式,或者說 sparse coding 方式有許多優點,一方面可以用少量的神經元對大量的特征進行編碼,另一方面也能降低解碼誤判以及能量損耗等等。

這篇文章的工作正是將 Sparse firing 與 HMAX 模型相結合,應用于圖像識別任務當中。工作非常有意思,感興趣的讀者不妨一讀。

二、視覺識別驗證碼

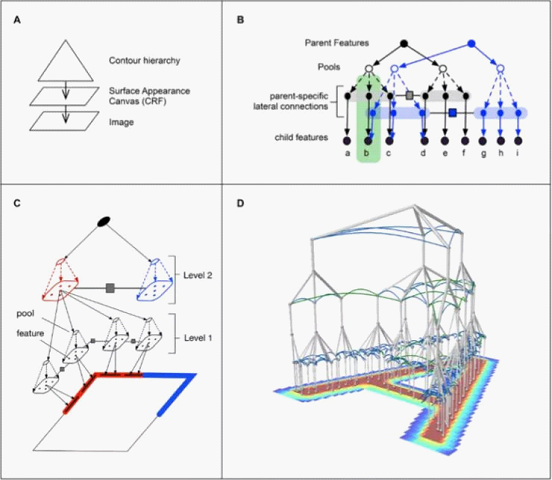

論文:A generative vision model that trains with high data efficiency and breaks text-based CAPTCHAs ( Science, 26 Oct. 2017)

這篇文章于今年 10 月份發表于《Science》期刊,是人工智能向神經科學學習的一個范例。

目前的機器學習模型在圖像識別的任務中往往需要大量的訓練數據集,而訓練的結果往往只能應用于特定的領域內。但人類的視覺智能則可以通過少數樣本(甚至不需要樣本)來學習并能夠很輕易地遷移到完全不同的情景當中。所以向人類的視覺神經機理學習或許是機器學習模型進一步發展的方向。

在這篇文章中,知名的人工智能創業公司 Vicarious 就通過人類視覺一些工作機理的啟發,構建了一個層級模型,他們稱之為「遞歸皮層網絡」(Recursive Cortical Network, RCN)。在模型中他們引入了視覺概率生成的模型框架,其中基于消息傳送(message-passing)的推斷,以統一的方式處理圖像的識別、分割和推理(Reasoning)。

這個方法表現出了非常優秀的泛化和遮擋推理(occlusion-reasoning)能力,在困難的場景文字識別任務上遠優于深度神經網絡,且具有 300 倍的數據效率(data efficient)優勢。

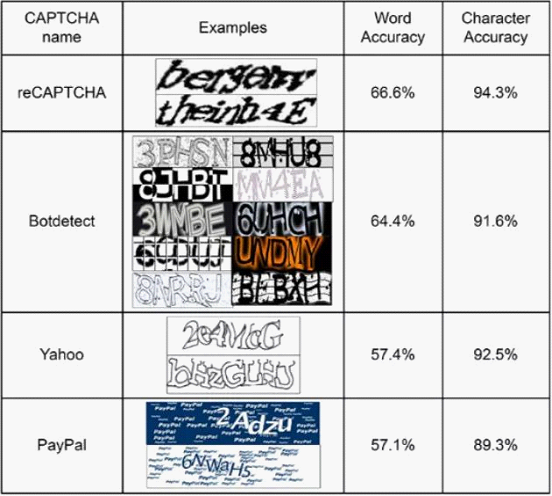

其實驗結果如下表

在 reCAPTCHA 的驗證碼單詞識別準確率已經可以達到 66.6%,BotDetect 為 64.4%,雅虎上為 57.4%,PayPal 上為 57.1%。

三、DNN 的可解釋性

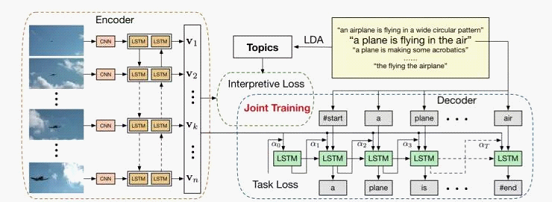

論文:Improving interpretability of deep neural networks with semantic information (2017)

這篇文章是張鈸院士組在 CVPR 2017 上的一篇論文,是「Knowledge+data」的一個典型范例。

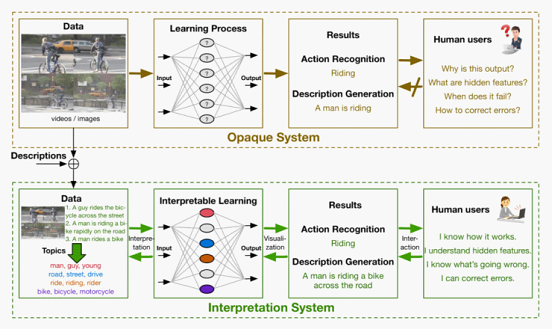

在傳統的圖像識別的 DNN 模型中,我們輸入圖片,得到描述性結果,但是我們卻不知道為什么會得到這樣的結果,也不知道隱藏層中都是什么 feature,或者當得到一個錯誤結果時我們不知道為什么會錯。

這篇文章的研究主要方法就是先獲得一些人類對圖片的描述作為語義信息數據;將這些數據和圖片同時送入到 DNN 模型中進行訓練;這里每一個神經元都會與一個 topic 進行關聯,于是整個網絡變得具有可解釋性。

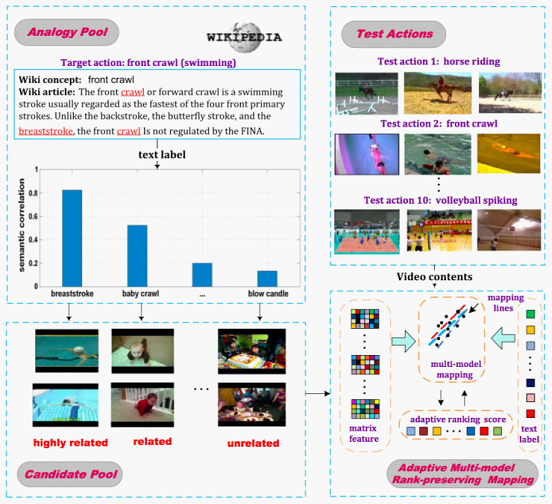

四、Zero-shot 視頻識別

論文:Recognizing an Action Using Its Name: A Knowledge-Based Approach

這篇文章的工作也是一個典型的「Knowledge+data」范例。

現有的動作識別算法需要一組正面的示例來訓練每個動作的分類器。但是,我們知道,動作類的數量非常大,用戶的查詢變化也很大。預先定義所有可能的行動類別是不切實際的。

在本文中作者提出了一種不需要正面示例的方法,通常這種方法被稱為「Zero-shot Learning」。目前的零點學習模式通常訓練一系列屬性分類器,然后根據屬性表示識別目標動作。為了確保特定動作類別的最大覆蓋范圍,基于屬性的方法需要大量可靠且準確的屬性分類器,這在現實世界中通常是不可用的。

在這篇論文中,作者提出的方法只需要一個行動名稱作為輸入來識別感興趣的行為,沒有任何預先訓練的屬性分類器和正面的示例。

給定一個動作名稱后,首先根據外部知識(例如 Wikipedia)建立一個類比池,類比池中的每個動作都會與不同層次的目標動作有關。

從外部知識推斷的相關性信息可能是嘈雜的。所以他們又提出一種算法,即自適應多模型秩保持映射(Adaptive multi-model rank-preserving mapping model, AMRM)來訓練動作識別的分類器,能夠自適應地評估類比池中每個圖片的相關性。

以上四個例子有兩類,一類是向神經科學學習的結果;一類是基于「數據+知識」的結果。(公眾號后臺發送「張鈸」,獲取四篇案例論文原文)

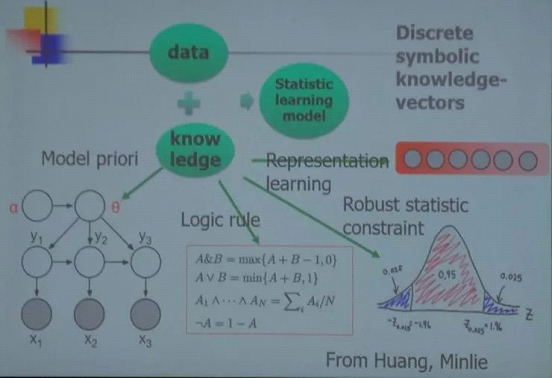

張鈸院士介紹說他們工作的一個思路就是:數據+知識=統計學習模型。其中知識包括先驗模型、邏輯規則、表示學習、強健的統計約束等。

此外他還提到了的 Bayesian Deep Learning 的概念。

最后他認為我們目前的 AI 系統是在介觀層面上模仿了人類,我們還需要向神經科學學習和合作。在 AI 系統的研究中應當將知識驅動和數據驅動結合起來,將理性行為和感性行為結合起來。

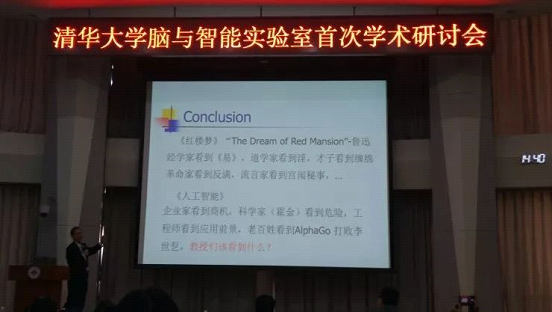

總結(劃重點)

張鈸院士演講的亮點在最后的 summary,原文整理如下(稍作修改):

魯迅說到,不同的人對《紅樓夢》有不同的看法,經濟學家看到《易》,道學家看到淫,才子看到纏綿,革命家看到反滿,流言家看到宮闈秘事。

現在的人工智能有點兒像《紅樓夢》,不同的人有不同的看法。企業家看到商機,科學家(霍金)看到危險,工程師看到應用前景,老百姓看到 AlphaGo 打敗李世石。我現在就說教授們應該看到什么,這也是我今天報告希望大家能夠看到的。

看到什么呢?就是——AI 科學的曙光。

大家看待 AI,有兩個過程。過去是低看了 AI,覺得 AI 沒什么。現在 AlphaGo 出來以后,突然 AI 上天了,大家對它仰視了。我告訴大家,這兩個都不對。大家要平視 AI。

為什么過去對 AI 有這個印象呢?確實,過去的 AI 我們沒有資格去談,因為我們只有猜測、假設,只有 case by case。我們沒有什么本事。再加上有些人炒作,不靠譜的東西很多。所以過去我們不能給大家談。

現在我們有希望給大家談的,就是剛才講的。現在從深度學習中大家看到的是廣泛的應用。但是沒有看到深度學習給我們點燃了一個曙光,就是人工智能完全可以用建立數學模型的方法來做。當然它也告訴我們,光用數學的方法來建造人工智能是不行的,例如深度學習獲得的結果只是一個機械的分類器,這跟人的認知或感知完全是兩碼事。

那么我們接下來怎么走向建造人工智能的數學模型這一步呢?只有兩條路。一條就是向腦科學學習,看大腦里面是怎么做到智能的。大腦里面也是使用神經網絡, 為什么它可以認識「鳥」,而計算機就不行呢?我們很清楚,計算機的這個神經網絡和大腦的神經網絡不可同日而語。我們必須向大腦學習。

另一條路就是把知識和數據結合起來。大家想一想,人的智能主要不是來自于數據,而是來自于知識。但是為什么大家要把數據看得這么重呢?這是因為數據很多,而且計算機最擅長的就是數據的處理。所以就給大家一個模糊的認識,以為數據決定一切。這是錯的。但是這也給我們提了個希望,既然計算機搞數據厲害,人利用知識厲害,如果我們能夠讓這兩個結合起來,我們就有希望做出比人還要好的系統。

問:張老師您好。您最后一個 slice 說在 AI 中商人看到了商機等等。所以我特別想知道您最后問的問題的答案,教授們應該看到的什么?

張鈸:教授應當看到的是——去做人工智能的基礎問題。我們不能去看那個商機,商機應該讓企業家去看。我現在認為人工智能正處在突破的前夜。深度學習不是我們的突破,深度學習只是展示了突破的希望,因為深度學習并沒有構造真正的 Intelligence。

現在我們有機會觸及到 the core of intelligence。在什么情況下我們才有可能觸碰 the core of intelligence 呢?就是剛才我講那 5 個條件,即

●在缺乏知識和數據的情況下依然能夠完成任務;

●在信息不完善(甚至缺乏信息)的情況下依然能夠完成任務;

●能夠處理非確定性的任務;

●能夠處理動態任務;

●能夠處理多領域和多任務。

現在的人工智能做的并不是真正的智能。它是選擇了那些確定性的、靜態的問題,這個本來就是計算機會干的事。計算機不會干的事是隨機應變,舉一反三,由表及里,這才是智能的本質。我們過去做的系統,沒法做到智能的本質,因為我們還不知道。深度學習給了我們一個提示,就是我們已經接觸到了智能的本質。那么我們沿著這個去做,才有希望。

大家現在都在消費深度學習。我們都知道,如果用深度學習來做識別,把石頭看成人沒有關系;但是做決策,把敵人看成朋友是不允許的。深度學習不解決這個問題,它絕對會產生大錯。這是它本質造成的。 所以我一直說,到目前為止,在復雜路況下,還很難實現真正的無人車,「無人車」旁邊還需要坐一個人。為什么?稍微懂點人工智能的人都知道,目前人工智能還不能解決突發事件。

過去我們沒有能力做到真正智能這一點。而今天是科學研究人員的一個機會。希望大家去做。如果大家持續去做,我相信會有新的發現。現在很多人看到了商機,看到了應用,看到了計算機打敗李世石,但卻很少人有看到這一點。局外人看不清,作為局內人,我提醒大家,教授應當看到——AI 科學的曙光。